在 Python 中,URL 解码(也称为百分比解码)可以通过多种方式实现,以下是几种常见的方法,从标准库到第三方库,并附有详细说明和示例。

使用标准库 urllib.parse (推荐)

这是最常用、最标准的方法,适用于绝大多数情况,Python 的标准库 urllib.parse 模块提供了 unquote() 函数专门用于此目的。

基本用法

urllib.parse.unquote() 会将 后跟的两个十六进制字符转换成对应的 ASCII 字符。

from urllib.parse import unquote

# 示例 1: 解码包含空格和特殊字符的 URL

encoded_url = "https://example.com/search?q=Python%20%E7%BC%96%E7%A8%8B&lang=zh-CN"

decoded_url = unquote(encoded_url)

print(f"编码前: {encoded_url}")

print(f"解码后: {decoded_url}")

# 输出:

# 编码前: https://example.com/search?q=Python%20%E7%BC%96%E7%A8%8B&lang=zh-CN

# 解码后: https://example.com/search?q=Python 编程&lang=zh-CN

# 示例 2: 解码 ASCII 字符

encoded_str = "Hello%20World%21"

decoded_str = unquote(encoded_str)

print(f"编码前: {encoded_str}")

print(f"解码后: {decoded_str}")

# 输出:

# 编码前: Hello%20World%21

# 解码后: Hello World!

处理非 UTF-8 编码的 URL

默认情况下,unquote() 会将解码后的字节串按 UTF-8 编码来解释,如果你的原始 URL 使用了其他编码(Latin-1/ISO-8859-1),你需要先解码字节串,然后再用正确的编码进行解码。

from urllib.parse import unquote

# 假设一个使用 Latin-1 编码的 URL

# "café" 在 Latin-1 中是 'é',其十六进制表示为 E9

encoded_latin1_url = "https://example.com/item=caf%E9"

# 1. 先用 unquote 得到原始的字节串

byte_data = unquote(encoded_latin1_url, encoding='latin-1')

print(f"字节串: {byte_data}") # 输出: b'https://example.com/item=caf\xe9'

# 2. 再用正确的编码将字节串解码成字符串

decoded_latin1_str = byte_data.decode('latin-1')

print(f"编码前: {encoded_latin1_url}")

print(f"解码后 (Latin-1): {decoded_latin1_str}")

# 输出:

# 编码前: https://example.com/item=caf%E9

# 解码后 (Latin-1): https://example.com/item=café

使用第三方库 requests

如果你已经在使用 requests 库进行 HTTP 请求,它内部已经帮你处理了 URL 解码,当你访问 response.url 时,你得到的就是解码后的 URL。

import requests

# 发送一个 GET 请求,URL 中包含编码字符

url = "https://example.com/search?q=Python%20%E7%BC%96%E7%A8%8B"

response = requests.get(url)

# response.url 属性会自动返回解码后的 URL

print(f"原始请求 URL: {url}")

print(f"requests 解码后的 URL: {response.url}")

# 输出:

# 原始请求 URL: https://example.com/search?q=Python%20%E7%BC%96%E7%A8%8B

# requests 解码后的 URL: https://example.com/search?q=Python 编程

注意:这种方法只适用于你已经通过 requests 获取了响应的场景,不适用于孤立地解码一个 URL 字符串。

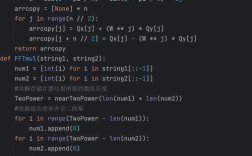

手动实现 (不推荐,仅用于理解原理)

了解手动实现可以帮助你理解 URL 解码的底层逻辑,这个实现只处理 ASCII 范围内的字符,对于非 ASCII 字符(如中文)会出错,除非你知道原始编码。

def manual_urldecode(encoded_str):

decoded_parts = []

i = 0

n = len(encoded_str)

while i < n:

if encoded_str[i] == '%' and i + 2 < n:

# 提取 % 后的两个字符,并转换为十六进制整数

hex_part = encoded_str[i+1:i+3]

try:

# 将十六进制字符转换为对应的 ASCII 字符

char_code = int(hex_part, 16)

decoded_parts.append(chr(char_code))

i += 3 # 跳过已处理的 %XX

except ValueError:

# %XX 不是有效的十六进制,则保留原样

decoded_parts.append(encoded_str[i])

i += 1

else:

# 如果不是 % 开头的编码序列,直接添加字符

decoded_parts.append(encoded_str[i])

i += 1

return "".join(decoded_parts)

# 测试

encoded_str = "Hello%20World%21"

decoded_str = manual_urldecode(encoded_str)

print(f"手动解码结果: {decoded_str}")

# 输出: 手动解码结果: Hello World!

# 这个方法对非 ASCII 字符会失败

# encoded_chinese = "%E7%BC%96%E7%A8%8B"

# print(manual_urldecode(encoded_chinese)) # 会输出乱码或报错

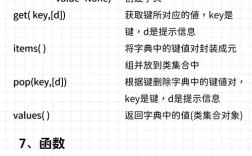

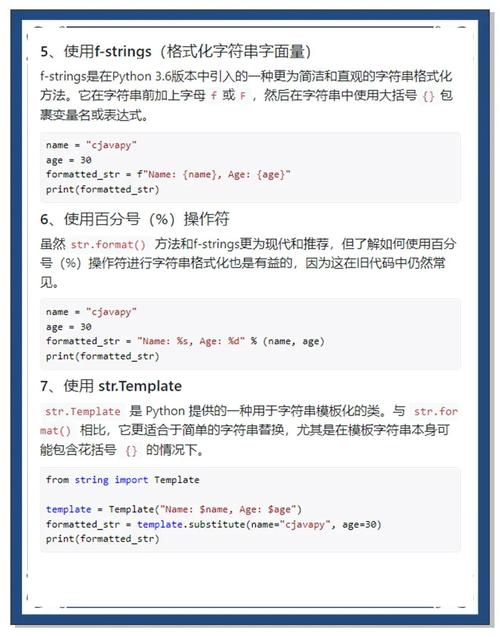

总结与对比

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

urllib.parse.unquote() |

标准、可靠、安全,支持 UTF-8 及其他编码 | 需要额外处理非 UTF-8 编码 | 绝大多数情况下的首选,通用性最强。 |

requests.response.url |

非常方便,无需手动调用 | 依赖于 requests 库,且必须已发起请求 |

在使用 requests 进行网络请求后,获取最终解码的 URL。 |

| 手动实现 | 有助于理解原理 | 代码复杂、易出错、不健壮(如处理编码问题) | 学习目的,不推荐在生产环境中使用。 |

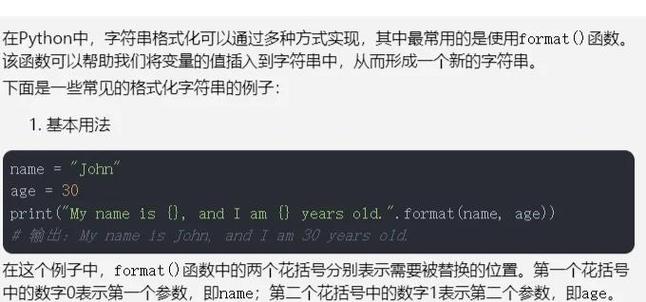

最佳实践

-

优先使用

urllib.parse.unquote():这是 Python 官方推荐的方式,也是最健壮的方式。 -

明确编码:如果你的 URL 确实不是 UTF-8 编码的(一些旧的系统或特定地区网站可能使用

latin-1或gbk),请务必在unquote()中指定正确的encoding参数,否则会得到乱码。 (图片来源网络,侵删)

(图片来源网络,侵删)# 示例:处理 GBK 编码的 URL encoded_gbk_url = "%B9%E3%CA%A1%BC%AE" decoded_gbk_str = unquote(encoded_gbk_url, encoding='gbk') print(decoded_gbk_str) # 输出: 欢迎你

-

处理 URL 组件 vs. 完整 URL:

unquote()会解码字符串中的所有%XX序列,如果你只想解码 URL 的某个部分(如查询参数q=的值),最好先将 URL 解析成组件,然后只解码需要的部分。urllib.parse.parse_qs和urllib.parse.parse_qsl函数在解析查询参数时会自动进行解码。from urllib.parse import urlparse, parse_qs url = "https://example.com/search?q=Python%20%E7%BC%96%E7%A8%8B&page=1" parsed_url = urlparse(url) query_params = parse_qs(parsed_url.query) # parse_qs 已经自动解码了参数值 print(query_params) # 输出: {'q': ['Python 编程'], 'page': ['1']}