Python MapReduce串联实战:从入门到构建高效数据处理流水线

(Meta Description)

本文详细讲解Python中MapReduce的核心概念与串联技巧,通过图文并茂和完整代码示例,手把手教你如何将多个MapReduce作业串联成一个高效的数据处理流水线,解决复杂的大规模数据计算问题,提升你的Python数据处理能力。

开篇引言:当“小问题”遇上“大数据”

在当今数据爆炸的时代,我们时常面临这样的挑战:如何从TB级甚至PB级的数据中提取有价值的信息?当单机处理能力捉襟见肘时,分布式计算框架应运而生,而MapReduce,作为Hadoop生态的基石思想,以其“分而治之”的哲学,为我们提供了一套优雅的解决方案。

你可能已经熟悉了Python中基础的map()和reduce()函数,它们是函数式编程的利器,但真正的MapReduce远不止于此,它是一种可以在集群上并行处理海量数据的编程模型,我们将深入探讨一个更高级、更贴近实际生产场景的话题——Python MapReduce串联,我们将学习如何将多个独立的MapReduce作业像流水线一样连接起来,处理从数据清洗、转换到聚合分析的复杂流程。

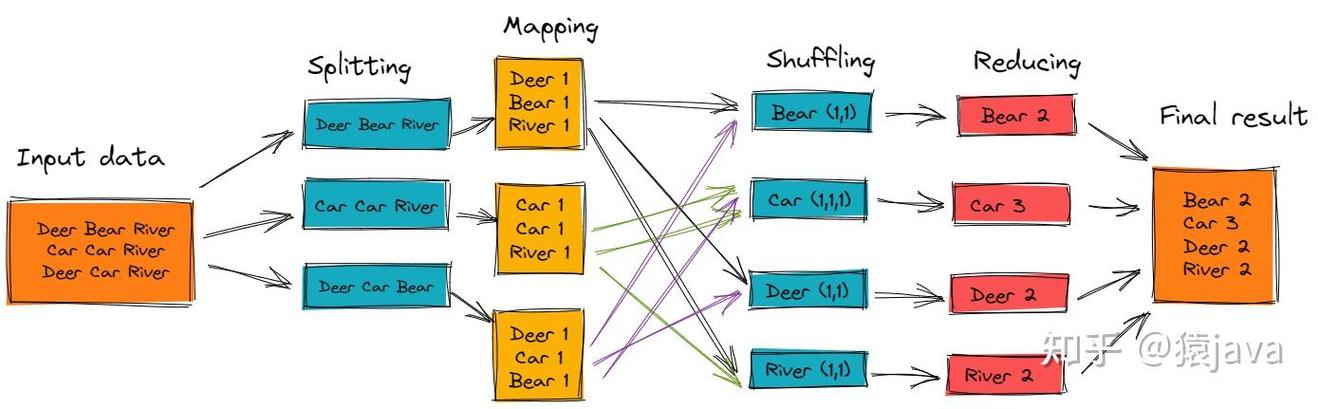

MapReduce核心思想回顾:分而治之的艺术

在深入串联之前,让我们快速回顾一下MapReduce的两大核心步骤:

-

Map阶段(映射):

- 输入:一组原始数据(文本文件的每一行)。

- 处理:对输入数据进行独立处理,并输出一系列

<key, value>键值对,这个阶段是“并行”的,每个数据块都可以被独立地映射。 - 示例:在单词计数中,Map函数将一行文本拆分成单词,并输出

<单词, 1>。

-

Reduce阶段(规约):

- 输入:Map阶段输出的、经过分组和排序后的

<key, list<value>>对。 - 处理:对每个

key对应的value列表进行聚合计算,最终得到最终结果。 - 示例:在单词计数中,Reduce函数接收

<单词, [1, 1, 1, ...]>,并将列表求和,输出<单词, 总数>。

- 输入:Map阶段输出的、经过分组和排序后的

关键点:MapReduce的魅力在于其“无状态”和“纯函数”的特性,这使得Map和Reduce任务可以高度并行化,从而在分布式集群上实现惊人的处理速度。

为何需要“串联”?——从单一作业到复杂流水线

单个MapReduce作业功能强大,但它通常只解决一个特定的问题,一个作业可以统计词频,另一个作业可以计算用户平均年龄,但现实世界中,我们的任务往往是多步骤的:

- 场景示例:分析电商网站的用户购买行为。

- 第一步(作业1):清洗原始日志数据,过滤掉无效点击,并提取

<用户ID, 商品类别, 购买金额>。 - 第二步(作业2):基于作业1的清洗结果,按

用户ID分组,计算每个用户的总消费金额和购买商品类别数。 - 第三步(作业3):基于作业2的聚合结果,按

总消费金额进行排序,筛选出高价值用户。

- 第一步(作业1):清洗原始日志数据,过滤掉无效点击,并提取

这个多步骤的过程,就是MapReduce作业的串联,后一个作业的输入,是前一个作业的输出,这种模式构建了一个数据处理流水线,每个环节专注于一件事,最终共同完成一个复杂的分析任务。

Python实现MapReduce串联:代码与实战

在Python生态中,我们通常不直接用Python语言编写Hadoop MapReduce程序(因为JVM开销和性能问题),而是使用更高效、更Pythonic的库,如 PySpark,PySpark是Apache Spark的Python API,它完全兼容MapReduce思想,并且提供了简洁的API来构建复杂的处理流程。

下面,我们通过一个完整的例子来演示如何串联两个MapReduce作业。

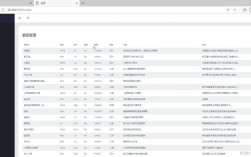

任务目标:

- 作业1:从一段包含

<用户, 商品, 价格>的文本中,筛选出所有价格大于100的商品,并输出<用户, 商品>。 - 作业2:接收作业1的输出,统计每个用户购买了多少件“高价值”商品。

环境准备:

确保你已经安装了PySpark,如果没有,可以通过pip安装:

pip install pyspark

作业1:数据筛选

这个作业的Map和Reduce逻辑可以合并到一个map函数中,因为我们不需要对同一个key的多个value进行聚合,而是对每条记录进行转换和过滤。

from pyspark.sql import SparkSession

# 初始化SparkSession

spark = SparkSession.builder.appName("MapReduce_Chaining_Job1").getOrCreate()

sc = spark.sparkContext

# 模拟原始数据

# 格式: "用户ID,商品名称,价格"

raw_data = [

"user1,iphone,999",

"user2,laptop,1200",

"user1,earphone,199",

"user3,book,50",

"user2,monitor,800",

"user1,ipad,599"

]

# 创建一个RDD (弹性分布式数据集)

rdd = sc.parallelize(raw_data)

# 定义作业1的Map函数

# 输入: 一行字符串

# 输出: (用户ID, 商品名称) 或 None (如果价格不满足条件)

def job1_map(line):

parts = line.split(',')

if len(parts) == 3:

user, product, price_str = parts

try:

price = float(price_str)

# 筛选条件:价格 > 100

if price > 100:

return (user, product)

except ValueError:

pass # 忽略价格格式错误的数据

return None # 不满足条件的数据返回None

# 执行作业1

# filter(None) 用于过滤掉返回None的记录

job1_result_rdd = rdd.map(job1_map).filter(lambda x: x is not None)

# 打印作业1的结果

print("--- 作业1结果:筛选出高价值商品 ---")

for item in job1_result_rdd.collect():

print(item)

# 输出:

# --- 作业1结果:筛选出高价值商品 ---

# ('user1', 'iphone')

# ('user2', 'laptop')

# ('user1', 'earphone')

# ('user2', 'monitor')

# ('user1', 'ipad')

作业2:用户购买统计

我们将作业1的结果作为作业2的输入,作业2需要统计每个用户购买了多少件高价值商品,这是一个典型的<key, list<value>>聚合场景,非常适合使用reduceByKey。

# 作业2的输入就是作业1的输出: job1_result_rdd

# 定义作业2的Reduce函数

# 输入: (key, list of values)

# 输出: (key, sum of values)

# 在这个例子中,value是商品名,我们只需要计数,所以可以忽略value的具体内容

def job2_reduce(a, b):

# a和b是两个value,但我们只需要知道它们的存在,所以直接计数即可

# reduceByKey会自动处理key的分组,我们只需要对计数进行累加

return a + b

# 执行作业2

# 1. map: 将 (user, product) 转换为 (user, 1),表示每个商品记为1次购买

# 2. reduceByKey: 对同一个user的1进行求和

job2_result_rdd = job1_result_rdd.map(lambda x: (x[0], 1)).reduceByKey(lambda a, b: a + b)

# 打印作业2的最终结果

print("\n--- 作业2结果:用户高价值商品购买统计 ---")

for item in job2_result_rdd.collect():

print(f"用户 {item[0]} 购买了 {item[1]} 件高价值商品")

# 关闭SparkSession

spark.stop()

# 输出:

# --- 作业2结果:用户高价值商品购买统计 ---

# 用户 user1 购买了 3 件高价值商品

# 用户 user2 购买了 2 件高价值商品

串联的艺术:构建高效流水线

上面的例子清晰地展示了串联的核心思想:

- 数据流:原始数据 -> 作业1 -> 中间结果 -> 作业2 -> 最终结果。

- API链式调用:在PySpark中,我们可以将操作链式地写在一起,形成一条流畅的数据处理管道,这既美观又高效,因为Spark会进行延迟计算,它会先构建一个逻辑执行计划,只有当遇到

collect()、count()、save()等行动算子时,才会真正提交任务到集群执行。

让我们将上面的代码重构为更具“流水线”风格的代码:

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("MapReduce_Pipeline_Style").getOrCreate()

sc = spark.sparkContext

raw_data = [

"user1,iphone,999", "user2,laptop,1200", "user1,earphone,199",

"user3,book,50", "user2,monitor,800", "user1,ipad,599"

]

rdd = sc.parallelize(raw_data)

# 定义一个高阶函数来封装MapReduce作业

def run_job1(input_rdd):

def map_func(line):

parts = line.split(',')

if len(parts) == 3:

user, product, price_str = parts

try:

price = float(price_str)

if price > 100:

return (user, product)

except ValueError:

pass

return None

return input_rdd.map(map_func).filter(lambda x: x is not None)

def run_job2(input_rdd):

# 作业2的输入是作业1的输出 (user, product)

# 我们只需要计数,所以将product忽略,转换为(user, 1)

return input_rdd.map(lambda x: (x[0], 1)).reduceByKey(lambda a, b: a + b)

# 构建并执行串联的流水线

final_result_rdd = run_job2(run_job1(rdd))

print("--- 流水线式串联的最终结果 ---")

for item in final_result_rdd.collect():

print(f"用户 {item[0]} 购买了 {item[1]} 件高价值商品")

spark.stop()

这种模块化的方式,让每个作业的职责更加清晰,也方便了后续的维护和扩展,如果需要添加作业3,我们只需要再定义一个run_job3函数,并将其加入到流水线中即可。

进阶技巧与最佳实践

-

数据持久化:当一个RDD在流水线中被多次使用时(作业1的输出同时被作业2和作业3使用),为了避免重复计算,应该对中间结果进行持久化,使用

rdd.persist()或rdd.cache()可以将中间数据存储在内存或磁盘中,极大地提升性能。job1_result_rdd = run_job1(rdd).persist() # 持久化作业1的输出 job2_result = run_job2(job1_result_rdd) job3_result = run_job3(job1_result_rdd) # 作业3可以直接使用,无需重新计算

-

合理划分阶段:Spark会根据操作类型(如

map是窄依赖,reduceByKey是宽依赖)自动将DAG划分为不同的阶段,宽依赖会触发Shuffle操作,这是整个计算中最耗资源的部分,在设计串联作业时,尽量将Shuffle操作往后放,或者在Shuffle前后使用filter、map等窄依赖操作来减少数据量。 -

使用DataFrame/Dataset API:对于结构化数据,优先使用PySpark的DataFrame API,它基于Catalyst优化器,能自动生成更优化的执行计划,性能通常比基于RDD的API更好,代码也更简洁。

从“会写”到“会用”

Python MapReduce串联,是将MapReduce思想应用于解决复杂现实问题的桥梁,它不仅仅是代码的堆砌,更是一种系统化、模块化的数据处理思维。

通过本文的学习,你应该掌握了:

- MapReduce串联的核心概念和必要性。

- 如何使用PySpark在Python中实现多个MapReduce作业的串联。

- 如何构建清晰、高效、可扩展的数据处理流水线。

- 进阶的性能优化技巧。

希望这篇详尽的指南能帮助你从“会写”MapReduce,真正成长为“会用”MapReduce解决实际问题的专家,在大数据的世界里,掌握构建流水线的能力,将让你如虎添翼。