mechanize 是一个强大的 Python 库,它模拟了网页浏览器的行为,允许你以编程方式与网站进行交互,这对于网络爬虫、自动化测试、数据抓取等任务非常有用。

目录

mechanize简介- 安装

- 核心概念与工作流程

- 详细 API 参考

- 创建浏览器实例 (

Browser) - 导航 (

open,reload) - 表单操作 (

select_form,form,set_value,submit) - 处理链接 (

links(),follow_link) - 处理 Cookies

- 配置请求头

- 响应处理 (

response,geturl(),getcode())

- 创建浏览器实例 (

- 完整代码示例

- 示例 1:访问网页并获取标题

- 示例 2:登录一个网站并获取受保护页面

- 注意事项与最佳实践

mechanizevs.requests+BeautifulSoup

mechanize 简介

mechanize 库的核心是 Browser 类,它创建了一个可编程的浏览器实例,这个“浏览器”可以:

- 遵循 HTTP 重定向:自动处理 301, 302 等重定向。

- 处理 Cookies:自动存储和发送 Cookie,模拟登录状态。

- 解析和填充 HTML 表单:自动解析页面中的表单,让你可以像用户一样输入文本、选择选项、点击复选框等。

- 处理链接:可以方便地查找和点击页面上的链接。

- 设置自定义请求头:可以模拟不同浏览器或爬虫的 User-Agent 等。

- 处理历史记录:可以像浏览器一样前进和后退。

安装

使用 pip 进行安装:

pip install mechanize

核心概念与工作流程

使用 mechanize 的典型流程如下:

- 导入库:

import mechanize - 创建浏览器实例:

br = mechanize.Browser() - 配置浏览器(可选):设置 User-Agent、超时时间等。

- 打开 URL:

br.open("http://example.com") - 查看/解析页面:获取页面内容、标题、表单、链接等。

- 与页面交互:

- 选择并填写表单。

- 点击链接。

- 提交表单或请求:

br.submit()或br.follow_link() - 处理响应:获取新页面的内容、状态码等。

- 重复步骤 5-8,直到完成目标。

- 关闭浏览器(可选):

br.close()

详细 API 参考

1 创建浏览器实例 (Browser)

import mechanize

# 创建一个浏览器实例

br = mechanize.Browser()

# 配置一些常用选项

br.set_handle_robots(False) # 不遵守 robots.txt 规则(爬虫礼貌,请谨慎使用)

br.set_handle_equiv(True) # 处理 Content-Type 等头部

br.set_handle_gzip(True) # 处理 gzip 压缩

br.set_handle_redirect(True) # 处理重定向

br.set_handle_referer(True) # 自动设置 Referer 头

br.set_handle_robots(False) # 不遵守 robots.txt 规则

br.addheaders = [('User-agent', 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36')]

2 导航 (open, reload)

-

br.open(url, data=None, timeout=None): (图片来源网络,侵删)

(图片来源网络,侵删)- 打开指定的 URL。

data:可选,用于 POST 请求的数据。- 返回一个

response对象,可以用来读取页面内容。 - 示例:

response = br.open("http://httpbin.org/get")

-

br.reload():重新加载当前页面。

3 表单操作 (select_form, form, set_value, submit)

这是 mechanize 最强大的功能之一。

-

选择表单:

br.select_form(form_name=None, predicate=None, nr=0) (图片来源网络,侵删)

(图片来源网络,侵删)-

form_name:通过表单的name或id属性选择。 -

nr:通过索引选择,nr=0是第一个表单。 -

predicate:一个函数,用于根据自定义条件选择表单。 -

示例:

# 选择第一个表单 br.select_form(nr=0) # 选择 name="login_form" 的表单 br.select_form(name="login_form")

-

-

访问选中的表单对象:

form = br.form获取当前选中的表单对象,可以查看其信息。

-

设置表单值:

-

br.form[key] = value:设置文本输入框、文本域。 -

br.set_value(value, name=None):更通用的设置方法。 -

对于单选框或复选框,值通常是字符串或字符串列表。

-

示例:

# 假设有一个名为 'username' 的文本输入框 br['username'] = 'my_user' # 假设有一个名为 'password' 的密码输入框 br['password'] = 'my_secret' # 假设有一个名为 'interests' 的复选框,值为 'coding' 和 'reading' br['interests'] = ['coding', 'reading'] # 假设有一个名为 'gender' 的单选框,值为 'male' br['gender'] = 'male'

-

-

提交表单:

br.submit():提交当前选中的表单。br.submitctl=None):提交指定的表单控件(按钮)。br.submit(nr=0):提交指定索引的表单。- 示例:

response = br.submit()

4 处理链接 (links(), follow_link)

-

br.links():- 返回一个包含页面所有链接的列表。

- 每个链接是一个

Link对象,包含url,text,name等属性。 - 示例:

for link in br.links(): print(f"链接文本: {link.text}, 链接地址: {link.url}")

-

br.follow_link(link=None, nr=0, **attrs):-

点击并跟随一个链接。

-

link:可以直接传入一个Link对象。 -

nr:跟随第nr个匹配的链接。 -

**attrs:通过链接的属性(如text,name,url)来查找。 -

示例:

# 跟随第一个链接 br.follow_link(nr=0) # 跟随文本为 "Next Page" 的链接 br.follow_link(text_regex=r"Next Page") # 跟随 name="continue" 的链接 br.follow_link(name="continue")

-

5 处理 Cookies

mechanize 会自动处理 Cookies,你也可以手动操作:

br.set_cookie(name, value, domain, path):手动设置一个 Cookie。br.handle_cookies():启用或禁用 Cookie 处理(默认启用)。

6 配置请求头

通过 addheaders 属性可以添加或修改请求头。

br.addheaders = [('User-agent', 'My-Crawler/1.0')]

br.addheaders.append(('Accept-Language', 'en-US,en;q=0.9'))

7 响应处理

br.response:获取当前页面的response对象。response.geturl():获取最终响应的 URL(可能经过了重定向)。response.getcode():获取 HTTP 状态码,如 200, 404, 500。response.info():获取响应头信息。response.read():读取页面内容(字节流)。response.read().decode('utf-8')解码为字符串。

br.title():获取页面的<title>标签内容。

完整代码示例

示例 1:访问网页并获取标题

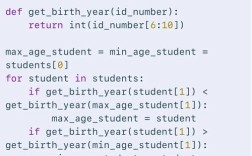

import mechanize

def get_page_title(url):

try:

br = mechanize.Browser()

# 设置 User-Agent

br.addheaders = [('User-agent', 'Mozilla/5.0')]

# 打开 URL

response = br.open(url)

# 获取标题

title = br.title()

print(f"页面标题: {title}")

# 获取页面内容

content = response.read().decode('utf-8')

# print(f"页面内容前 200 字符: {content[:200]}")

except mechanize.HTTPError as e:

print(f"HTTP 错误: {e.code} {e.reason}")

except Exception as e:

print(f"发生错误: {e}")

finally:

br.close()

# 使用示例

get_page_title("http://example.com")

# 输出: 页面标题: Example Domain

示例 2:登录一个网站并获取受保护页面

这个例子模拟了登录 httpbin.org/post 的过程,这是一个测试网站,它会 POST 你提交的数据并返回给你。

import mechanize

import json

def login_and_access_protected_page(login_url, username, password):

br = mechanize.Browser()

br.set_handle_robots(False)

br.addheaders = [('User-agent', 'Mozilla/5.0')]

try:

# 1. 打开登录页面

print(f"正在打开登录页面: {login_url}")

br.open(login_url)

# 2. 选择并填写表单

# 通常登录表单是页面上的第一个表单

br.select_form(nr=0)

# 假设表单的用户名输入框叫 'username',密码叫 'password'

# (你需要根据目标网站的实际表单结构调整)

br['username'] = username

br['password'] = password

print("正在提交登录表单...")

# 3. 提交表单

response = br.submit()

# 4. 检查登录是否成功

# 通常登录成功后会跳转,或者页面内容会改变

# 我们可以检查 URL 或页面内容来判断

if "login" in br.geturl().lower():

print("登录失败!URL 仍包含 'login'。")

return

else:

print(f"登录成功!当前 URL: {br.geturl()}")

# 5. 访问需要登录才能查看的页面

# 假设这个页面就在登录后跳转的页面

# 或者我们可以手动访问另一个页面

# protected_page_url = "http://httpbin.org/headers" # 这个页面不需要登录

# response = br.open(protected_page_url)

# 6. 获取页面内容

content = response.read().decode('utf-8')

print("\n受保护页面的内容:")

print("-" * 20)

print(json.dumps(json.loads(content), indent=2, ensure_ascii=False))

print("-" * 20)

except mechanize.HTTPError as e:

print(f"HTTP 错误: {e.code} {e.reason}")

except Exception as e:

print(f"发生错误: {e}")

finally:

br.close()

# 使用示例

# 注意:httpbin.org/post 是一个通用的 POST 端点,不是真实的登录页面

# 这里仅用于演示 mechanize 如何处理表单提交

# 在真实场景中,你需要找到真实的登录 URL 和表单字段名

login_url = "http://httpbin.org/post"

username = "testuser"

password = "testpassword"

login_and_access_protected_page(login_url, username, password)

注意事项与最佳实践

robots.txt:br.set_handle_robots(False)会忽略robots.txt文件,在生产爬虫中,最好遵守这些规则,可以使用urllib.robotparser来检查。- 网站反爬:现代网站有强大的反爬机制,频繁的请求、固定的 User-Agent 等很容易被识别,可以:

- 使用代理 IP 池。

- 随机化 User-Agent。

- 在请求之间添加随机延迟(

import time; time.sleep(random.uniform(1, 3)))。

- JavaScript:

mechanize不能执行 JavaScript,如果页面内容是通过 JS 动态加载的,mechanize将无法获取到,对于这类网站,你需要使用Selenium或Playwright等可以控制真实浏览器的工具。 - 错误处理:网络请求可能会失败(超时、404、500等),务必使用

try...except块来捕获mechanize.HTTPError和其他可能的异常。 - HTML 结构变化:网站可能会更新其 HTML 结构(如表单的

name属性改变),这会导致你的脚本失效,需要定期维护脚本。

mechanize vs. requests + BeautifulSoup

这是一个常见的选择题。

| 特性 | mechanize |

requests + BeautifulSoup |

|---|---|---|

| 易用性 | 高,封装了浏览器行为,操作直观。 | 中,需要分两步:requests 获取数据,BeautifulSoup 解析。 |

| 表单处理 | 非常强大,自动选择和填充表单。 | 较弱,需要手动解析 HTML 找到表单和输入框的 name,然后构造 data 字典。 |

| JavaScript | 不支持 | 不支持 (但 requests 本身也不支持) |

| 功能范围 | 专注于模拟浏览器交互。 | requests 是万能的 HTTP 客户端,BeautifulSoup 是强大的 HTML/XML 解析器,组合更灵活。 |

| 性能 | 相对较慢,因为它是一个状态机,模拟了浏览器的很多逻辑。 | 非常快,requests 底层是 urllib3,性能极高。 |

| 推荐场景 | - 自动化登录 - 爬取需要处理复杂会话、表单和重定向的网站。 |

- 绝大多数爬虫场景 - 快速 API 调用 - 抓取静态 HTML 页面 - 需要高性能时。 |

对于大多数现代爬虫任务,requests + BeautifulSoup (或 lxml) 是更现代、更高效、更灵活的选择。mechanize 在处理需要模拟浏览器表单提交的旧式网站时依然有其价值。

mechanize 是一个经典的 Python 爬虫库,它通过模拟浏览器行为,极大地简化了与网站的交互过程,尤其是在处理表单和会话方面,尽管在 JavaScript 支持和高性能方面不如现代方案,但它的 API 设计直观,对于特定任务(如自动化登录)依然非常有效。

希望这份文档能帮助你快速上手 mechanize!