核心方法:decode() 和 encode()

这是 Python 字符串处理的基础。

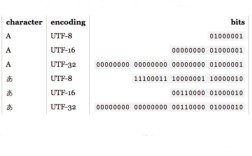

decode(encoding): 将字节串(bytes)按照指定的encoding解码成字符串(str)。encode(encoding): 将字符串(str)按照指定的encoding编码成字节串(bytes)。

转换的流程就是:bytes (ANSI) -> decode('ANSI编码') -> str (Unicode) -> encode('utf-8') -> bytes (UTF-8)

硬编码 ANSI 编码名(不推荐,但最简单)

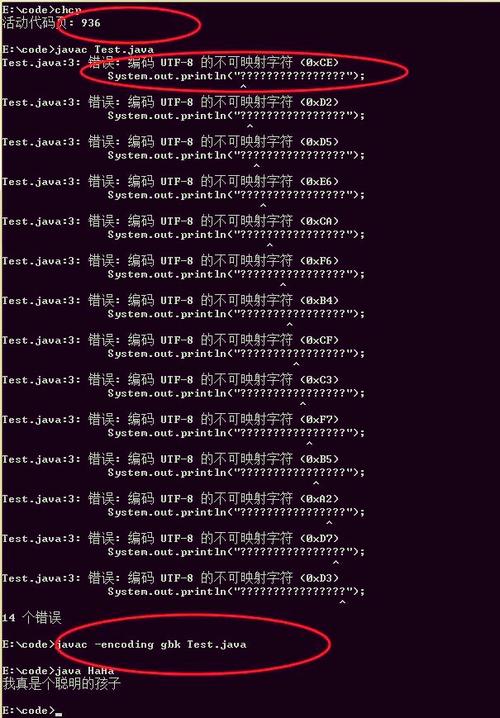

如果你确切知道你的 ANSI 文件是哪种编码(cp1252,这是 Windows 中文版下的常见 ANSI 编码),可以直接指定。

假设你有一个名为 ansi_file.txt 的文件,内容为中文 "你好,世界!",并以 gbk 编码保存。

# 1. 以二进制模式读取 ANSI 文件,得到字节流

with open('ansi_file.txt', 'rb') as f:

ansi_bytes = f.read()

# 打印原始字节流,可以看到它不是 UTF-8 格式

print("原始字节流:", ansi_bytes) # 输出: b'\xB9\xE3\xCA\xA1\xBC\xFE\xCA\xA1\xCA\xA1\xBD\xE2\x21'

# 2. 将字节流解码为字符串 (假设我们知道它是 gbk 编码)

# 如果猜错编码,这里会抛出 UnicodeDecodeError 错误

unicode_str = ansi_bytes.decode('gbk')

print("解码后的字符串:", unicode_str) # 输出: 你好,世界!

# 3. 将字符串编码为 UTF-8 字节流

utf8_bytes = unicode_str.encode('utf-8')

print("UTF-8 字节流:", utf8_bytes) # 输出: b'\xe4\xbd\xa0\xe5\xa5\xbd\xef\xbc\x8c\xe4\xb8\x96\xe7\x95\x8c\xef\xbc\x81'

# 4. (可选) 将 UTF-8 字节流写回文件

with open('utf8_file.txt', 'wb') as f:

f.write(utf8_bytes)

print("转换完成,已保存为 utf8_file.txt")

问题:这种方法最大的问题是,你必须提前知道原始的 ANSI 编码,如果文件是 cp1252,你却用了 gbk,程序就会崩溃。

处理文件时直接转换(推荐)

在实际应用中,我们通常需要读取一个文件,处理后写入另一个文件,Python 的 open() 函数提供了非常便捷的参数来直接完成这个转换,无需手动处理 decode 和 encode。

这是最推荐、最 Pythonic 的方式。

读取 ANSI 文件,写入 UTF-8 文件

# 假设 ansi_file.txt 是 gbk 编码的

input_filename = 'ansi_file.txt'

output_filename = 'output_utf8.txt'

# 使用 'r' 模式打开 ANSI 文件,并用 encoding 参数指定其编码

# Python 会自动在内部完成 bytes -> str 的解码

with open(input_filename, 'r', encoding='gbk') as f_in:

# 使用 'w' 模式打开目标文件,并用 encoding 参数指定为 utf-8

# 当你写入字符串时,Python 会自动完成 str -> bytes 的编码

with open(output_filename, 'w', encoding='utf-8') as f_out:

for line in f_in:

f_out.write(line)

print(f"文件已从 '{input_filename}' (GBK) 转换为 '{output_filename}' (UTF-8)")

这种方法代码更简洁,且不易出错,因为 Python 的文件对象会帮你处理所有底层的编码转换。

读取 UTF-8 文件,写入 ANSI 文件

反过来,如果需要将 UTF-8 转换为 ANSI,方法也是一样的。

input_filename = 'utf8_file.txt' # 假设这是 UTF-8 编码的

output_filename = 'output_gbk.txt'

# 读取时指定源编码为 utf-8

# 写入时指定目标编码为 gbk (或其他 ANSI 编码)

with open(input_filename, 'r', encoding='utf-8') as f_in:

with open(output_filename, 'w', encoding='gbk') as f_out:

for line in f_in:

f_out.write(line)

print(f"文件已从 '{input_filename}' (UTF-8) 转换为 '{output_filename}' (GBK)")

自动检测编码(高级)

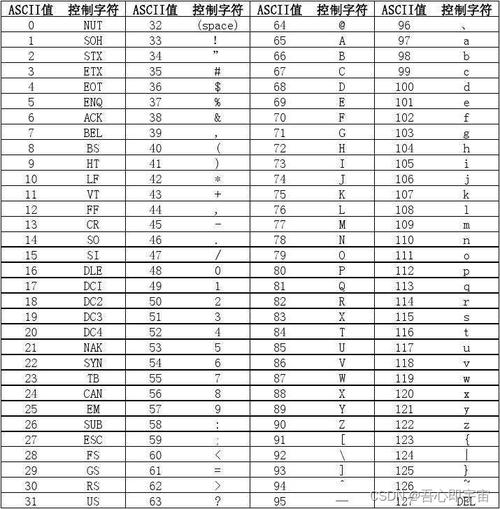

如果你无法确定 ANSI 文件的具体编码(可能是 gbk, gb2312, big5, cp1252 等),可以使用第三方库 chardet 来自动检测编码。

你需要安装它:

pip install chardet

你可以这样使用它:

import chardet

def convert_file_to_utf8(input_filename, output_filename):

# 1. 以二进制模式读取文件内容

with open(input_filename, 'rb') as f:

raw_data = f.read()

# 2. 使用 chardet 检测编码

# confidence 是置信度,越高越可信

result = chardet.detect(raw_data)

detected_encoding = result['encoding']

confidence = result['confidence']

print(f"检测到编码: {detected_encoding}, 置信度: {confidence:.2f}")

# 3. 根据检测结果进行解码和转换

# 如果置信度过低,可能需要手动干预

if confidence > 0.7: # 设置一个置信度阈值

try:

# 解码为字符串

unicode_str = raw_data.decode(detected_encoding)

# 编码为 UTF-8 并写入文件

with open(output_filename, 'w', encoding='utf-8') as f_out:

f_out.write(unicode_str)

print(f"成功将 '{input_filename}' 转换为 UTF-8,保存为 '{output_filename}'")

except UnicodeDecodeError:

print(f"错误:无法用检测到的编码 '{detected_encoding}' 解码文件。")

except LookupError:

print(f"错误:系统不支持检测到的编码 '{detected_encoding}'。")

else:

print(f"警告:编码检测置信度过低 ({confidence:.2f}),无法自动转换,请手动检查。")

# 使用示例

convert_file_to_utf8('ansi_file.txt', 'auto_detected_utf8.txt')

| 场景 | 推荐方法 | 示例代码 |

|---|---|---|

| 已知编码 | 使用 open() 的 encoding 参数(最推荐) |

with open('f.txt', 'r', encoding='gbk') as f: |

| 已知编码 | 手动 decode 和 encode |

s = b'...'.decode('gbk'); b = s.encode('utf-8') |

| 未知编码 | 使用 chardet 库自动检测 |

import chardet; result = chardet.detect(raw_data) |

对于绝大多数日常任务,方法二(在 open() 函数中指定 encoding) 是最简单、最可靠的选择,只有在处理来源不明、编码可能各异的文件时,才需要考虑使用 方法三(chardet 自动检测)。