Python Spark Union 完全指南:从入门到精通,告别数据合并烦恼!

** 深入解析 PySpark DataFrame union() 与 unionAll() 的用法、区别及最佳实践,助你高效处理大规模数据合并。

(Meta Description - 用于百度搜索展示)**

还在为 PySpark 中合并多个 DataFrame 而烦恼吗?本文全面讲解 Python Spark Union 操作,包括 union() 与 unionAll() 的核心区别、使用场景、代码示例及性能优化技巧,无论你是初学者还是资深开发者,这份从入门到精通的指南都将助你彻底掌握 Spark 数据合并,提升数据处理效率!立即阅读,解决你的实际问题。

内容**

引言:为什么你需要掌握 Spark Union?

在大数据处理的世界里,我们经常遇到需要将多个数据集合并成一个完整数据集的场景,将来自不同时间段的用户行为日志合并,或将不同来源的销售数据汇总,Apache Spark 作为业界领先的大数据处理框架,提供了强大的数据操作能力。

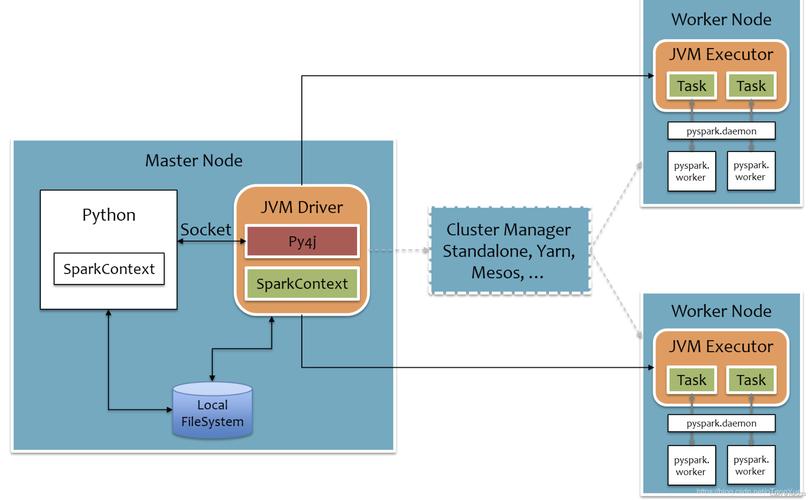

在 PySpark(Python for Apache Spark)中,union 是实现数据合并最基本也最重要的操作之一,许多开发者,尤其是初学者,对 union() 和 unionAll() 的区别、使用时机以及潜在的陷阱并不完全了解,常常导致程序运行效率低下,甚至产生错误的结果。

本文将作为你的“完全指南”,带你彻底搞懂 Python Spark Union,让你在数据处理的道路上更加游刃有余。

初识 PySpark DataFrame:数据合并的基石

在深入 union 操作之前,我们首先要明确操作的对象——PySpark DataFrame,DataFrame 是 Spark 中一种分布式的、基于 Schema 的数据集合,类似于关系型数据库中的表或 Python 中的 Pandas DataFrame,它提供了丰富的 API,支持对结构化数据进行各种操作,如过滤、排序、聚合等。

我们的目标就是将两个或多个具有相同或相似结构的 DataFrame 合并成一个更大的 DataFrame。union 系列函数正是为此而生。

核心解析:PySpark union() vs unionAll()

这是本文最核心的部分,很多教程会混用这两个函数,但实际上它们在 Spark 2.0 以后已经有了明确的“分工”。

1 union():保留去重能力的合并

union() 函数的作用是将两个 DataFrame 的行合并在一起。关键点在于,它会尝试移除合并后的 DataFrame 中的重复行。

工作原理:

union() 内部实际上是调用了 distinct() 操作,它在合并数据后,会对整个结果 DataFrame 进行一次去重。

语法:

df_union = df1.union(df2)

适用场景:

当你需要合并两个 DataFrame,并且不希望最终结果中出现任何重复的行时,union() 是你的首选。

代码示例:

from pyspark.sql import SparkSession

# 创建 SparkSession

spark = SparkSession.builder.appName("UnionExample").getOrCreate()

# 创建两个包含重复数据的 DataFrame

data1 = [("Alice", 1), ("Bob", 2), ("Charlie", 3)]

data2 = [("Alice", 1), ("David", 4), ("Bob", 2)]

columns = ["Name", "ID"]

df1 = spark.createDataFrame(data1, columns)

df2 = spark.createDataFrame(data2, columns)

print("DataFrame 1:")

df1.show()

print("DataFrame 2:")

df2.show()

# 使用 union() 合并,并自动去重

df_union_result = df1.union(df2)

print("Result of df1.union(df2):")

df_union_result.show()

# 为了更清晰地看到去重效果,我们也可以手动调用 distinct()

df_distinct_result = df1.union(df2).distinct()

print("Result of df1.union(df2).distinct() (same as above):")

df_distinct_result.show()

输出分析:

你会发现 df_union_result 的结果只有 3 行:("Alice", 1), ("Bob", 2), ("Charlie", 3), ("David", 4)。("Alice", 1) 和 ("Bob", 2) 这两条重复的记录被自动移除了。

2 unionAll():纯粹的行合并 (注意:Spark 2.0+ 已弃用)

unionAll() 函数的作用也是将两个 DataFrame 的行合并在一起。但关键区别在于,它会保留所有的行,包括完全重复的行。

重要提示:

在 Spark 2.0 及更高版本中,unionAll() 已经被标记为弃用 (deprecated),官方文档推荐直接使用 union(),因为 union() 的行为已经与 unionAll() 保持一致——即只进行行合并,不再自动去重。

语法 (已弃用,但了解其原理很重要):

# 不推荐使用 df_union_all = df1.unionAll(df2)

为什么会有这个变化?

这个改变是为了统一 API 的行为,避免混淆,开发者如果想要合并并保留重复项,直接使用 union() 即可,如果想要去重,则需要明确地调用 .distinct()。

现代 PySpark 的最佳实践:

在 Spark 2.0+ 版本中,df1.union(df2) 和 df1.unionAll(df2) 的效果是完全一样的,它们都会保留所有行,请忘记 unionAll,直接使用 union()。

进阶用法与注意事项

掌握了基本用法后,我们还需要了解一些进阶技巧和潜在问题,才能在实际项目中游刃有余。

1 Schema 的要求:列名和类型必须匹配!

union 操作有一个非常重要的前提:参与合并的 DataFrame 必须拥有相同的列数、相同的列名以及相同的列数据类型。

Spark 会按照列的顺序进行合并,而不是按照列名,Schema 不匹配,程序会直接抛出 AnalysisException。

错误示例:

# df1 有 (Name, ID)

# df3 有 (Employee, Salary)

df3 = spark.createDataFrame([("Eve", 50000)], ["Employee", "Salary"])

# df1.union(df3) # 这会抛出异常!

解决方案:

Schema 不完全相同,你需要先使用 .select() 或 .withColumnRenamed() 等工具对齐列名和类型。

# 假设 df2 的列名是 'name' 和 'id',与 df1 不同

df4 = spark.createDataFrame([("Frank", 5)], ["name", "id"])

# 解决方案:使用 withColumnRenamed 对齐列名

df4_renamed = df4.withColumnRenamed("name", "Name").withColumnRenamed("id", "ID")

df1.union(df4_renamed).show()

2 性能考量:union vs unionByName

当你的 DataFrame 列顺序完全一致时,union 是最高效的。

如果两个 DataFrame 的列顺序不同,但列名和类型是匹配的,使用 union 就会失败,这时,你需要使用 unionByName()。

unionByName() 会根据列名而不是列位置来合并 DataFrame,如果两个 DataFrame 中存在某列只在其中一个中存在,allowMissingColumns 参数可以控制如何处理(默认为 False,即报错)。

代码示例:

# df1 的列顺序是 (Name, ID)

# df5 的列顺序是 (ID, Name)

df5 = spark.createDataFrame([("6", "Grace")], ["ID", "Name"])

# 使用 union 会失败

# df1.union(df5) # 报错

# 使用 unionByName 可以成功

df_union_by_name = df1.unionByName(df5)

df_union_by_name.show()

3 处理重复行:union + distinct 的权衡

union() 虽然不再自动去重,但 union() + distinct() 的组合是处理数据去重的经典模式。

优点:

- 逻辑简单直观,一步完成合并和去重。

缺点:

- 性能开销巨大。

distinct()操作需要对整个数据集进行洗牌,并且需要计算所有行的哈希值进行比较,在数据量大的情况下非常耗时且消耗资源。

替代方案(如果适用):

如果你的数据来源是确定性的,并且你知道重复行只可能来自于源 DataFrame 之间的交集,而不是在单个源 DataFrame 内部,那么可以考虑先对每个源 DataFrame 进行 distinct(),然后再 union()。

# 方案A:先去重再合并 (可能更快,取决于数据分布) df_distinct_then_union = df1.distinct().union(df2.distinct()) # 方案B:先合并再去重 (逻辑更通用,但性能开销大) df_union_then_distinct = df1.union(df2).distinct()

选择哪种方案,需要根据你的具体业务逻辑和数据特征进行性能测试和权衡。

实战场景:日志数据合并案例

假设我们有一个电商网站,每天都会生成一个用户点击日志文件,我们需要将过去一周的日志数据合并起来,进行全量分析。

数据模拟:

logs_20251027.csvlogs_20251028.csvlogs_20251031.csv

PySpark 实现代码:

from pyspark.sql import SparkSession

import os

spark = SparkSession.builder.appName("LogMerger").getOrCreate()

# 假设日志文件都放在 'data/logs/' 目录下

log_dir = "data/logs/"

all_log_files = [os.path.join(log_dir, f) for f in os.listdir(log_dir) if f.startswith('logs_') and f.endswith('.csv')]

# 如果没有文件,则创建一个空的 DataFrame 作为初始值

initial_df = spark.sparkContext.emptyDataFrame.toDF(["user_id", "action", "timestamp"])

# 使用 reduce 和 union 逐步合并所有日志文件

# 这种方式比循环 union 更具函数式风格

final_logs_df = all_log_files.reduce(

lambda df, file: df.union(spark.read.csv(file, header=True, inferSchema=True)),

initial_df

)

print("合并后的总行数:", final_logs_df.count())

print("合并后的 Schema:")

final_logs_df.printSchema()

# 为了分析,我们可以先去重,然后按用户分组

unique_user_actions = final_logs_df.distinct()

user_action_counts = unique_user_actions.groupBy("user_id").count().orderBy("count", ascending=False)

print("Top 10 最活跃用户:")

user_action_counts.show(10)

spark.stop()

代码解读:

- 我们首先获取所有日志文件的路径列表。

- 使用

reduce函数。reduce会从一个初始值initial_df开始,依次将列表中的每个文件(file)与当前的累加器(df)进行合并操作。 spark.read.csv用于读取每个日志文件,并推断其 Schema。df.union(...)将新读取的 DataFrame 与累加器合并。- 我们得到一个包含所有日志数据的

final_logs_df,并进行了简单的去重和用户活跃度分析。

总结与最佳实践

恭喜你!现在你已经对 Python Spark Union 有了全面而深入的理解,让我们来总结一下核心要点和最佳实践:

- 首选

union():在 Spark 2.0 及以上版本,union()是唯一的、标准的合并函数,它会保留所有行,不再自动去重。 - Schema 必须匹配:确保参与合并的 DataFrame 具有相同的列名、列数和列数据类型,如果顺序不同,使用

unionByName()。 - 明确去重意图:

- 如果需要保留所有行,直接使用

df1.union(df2)。 - 如果需要合并并去重,使用

df1.union(df2).distinct()。 - 考虑

distinct()的性能开销,根据数据特征选择最优策略。

- 如果需要保留所有行,直接使用

- 拥抱

unionByName:当列顺序不一致但列名匹配时,unionByName()是你的救星。 - 处理大规模文件:对于需要合并大量文件(如每日日志)的场景,使用

reduce结合union是一种高效且优雅的函数式编程方法。

掌握这些技巧,你将能轻松应对各种 PySpark 数据合并挑战,让大数据处理变得简单而高效!

常见问题解答 (FAQ - 提升SEO和用户体验)

Q1: PySpark 中 union 和 join 有什么区别?

A: union 是纵向合并,将两个 DataFrame 的行堆叠在一起,要求列结构匹配。join 是横向关联,根据一个或多个键将两个 DataFrame 的列拼接在一起,类似于 SQL 的 JOIN 操作。

Q2: 如果两个 DataFrame 的列不完全一样,能 union 吗?

A: 不能。union 要求列名和类型完全一致,如果列名相同但顺序不同,用 unionByName,如果列本身就不一样,你需要先通过 select 或 withColumn 等操作创建一个临时的、结构一致的中间 DataFrame。

Q3: union 操作会触发 Shuffle 吗?

A: union 操作本身是一个窄依赖操作,它只是简单地将两个 RDD 的分区拼接起来,通常不会触发 Shuffle,如果你在 union 之后立即跟了 distinct() 或 groupBy() 等宽依赖操作,Shuffle 就会发生。

Q4: union 和 concat 在 PySpark 中是一样的吗?

A: 不一样。union 是 DataFrame API 的一部分,用于合并行,而 concat (或 pyspark.sql.functions.concat) 是一个函数,用于将列的值连接起来,生成一个新的列,它们的作用维度完全不同。

(文章结束)