(H1):Autoencoder Python 完全指南:从原理到实战,零基础掌握自编码器

Meta描述: 想学习用Python实现Autoencoder(自编码器)?本文是2025年最全面的教程,深入浅出讲解Autoencoder原理、代码实现、应用场景,并提供可直接运行的Python代码,助你从入门到精通。

引言:为什么Autoencoder是机器学习中的“瑞士军刀”?(H2)

在当今数据驱动的世界里,我们常常面临一个核心问题:如何在海量数据中提取有价值的信息? 无论是图像去噪、异常检测,还是数据降维可视化,都需要一种能够理解数据内在结构的强大工具。

我们要介绍的 Autoencoder(自编码器) 正是这样一种神器,它就像一位不知疲倦的“数据雕塑家”,能够学习如何压缩数据,然后再从压缩的“精华”中完美地重建原始数据,这个过程不仅让我们窥见了数据的本质,更解锁了无数令人惊叹的应用。

作为一名Python开发者,掌握Autoencoder不仅是提升技术栈的必经之路,更是解决实际问题的利器,本文将带你从零开始,用Python一步步揭开Autoencoder的神秘面纱。

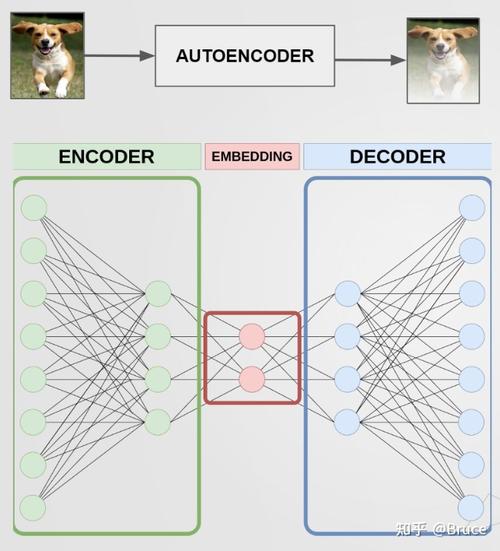

Autoencoder核心原理:它到底是如何工作的?(H2)

想象一下,你给一位艺术家看一幅复杂的画作,然后让他凭记忆重新画一遍,为了画得像,他必须先“理解”画作的精髓——比如构图、色彩和主要元素,而忽略无关的细节,Autoencoder的工作原理与此异曲同工。

它由两个核心部分组成:编码器(Encoder) 和 解码器(Decoder)。

编码器:数据的“压缩大师”(H3)

编码器是一个神经网络,它的任务是将输入数据(如图像、文本向量)压缩成一个低维度的、紧凑的表示,这个表示被称为 “潜在空间”(Latent Space) 或 “编码”(Code)。

- 输入层(Input Layer): 接收原始数据,例如一张 784 像素的 MNIST 手写数字图片。

- 隐藏层(Hidden Layers): 通过一系列的线性变换和非线性激活函数(如ReLU),逐步提取数据的特征,并不断降低数据的维度。

- 输出层(Bottleneck Layer): 生成最终的“编码”,这个编码是数据的精华,剔除了冗余信息。

解码器:数据的“重建艺术家”(H3)

解码器是另一个神经网络,它的目标与编码器相反:接收编码器生成的低维编码,并尝试从中重建出与原始输入尽可能接近的数据。

- 输入层: 接收来自编码器的“编码”。

- 隐藏层: 通过与编码器相反的结构(通常是维度逐渐增加),对编码进行“解码”和特征重组。

- 输出层: 生成重建后的数据,输出一张同样是 784 像素的图片。

损失函数:衡量“失真”的标尺(H3)

整个Autoencoder的训练过程,就是让重建数据与原始数据的差异最小化,这个差异由 损失函数 来衡量,对于图像数据,最常用的损失函数是 均方误差。

Loss = Mean Squared Error (原始图像, 重建图像)

通过反向传播算法,网络会不断调整编码器和解码器的权重,使得损失函数的值持续下降,最终实现“高保真”的重建。

Python实战:用Keras搭建你的第一个Autoencoder(H2)

理论说再多,不如动手写一行代码,我们将使用Python中最流行的深度学习框架——TensorFlow/Keras,来构建一个用于图像降噪的简单Autoencoder。

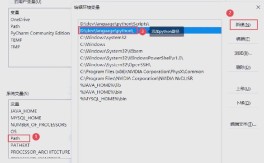

环境准备(H3)

确保你已经安装了必要的库:

pip install tensorflow numpy matplotlib

完整代码与详解(H3)

下面是一个完整的、可运行的示例,我们将使用经典的MNIST数据集,并人为地为图像添加噪声,然后训练Autoencoder来学习如何去除这些噪声。

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.keras import layers, models

# --- 1. 数据准备 ---

# 加载MNIST数据集

(x_train, _), (x_test, _) = tf.keras.datasets.mnist.load_data()

# 归一化像素值到 [0, 1] 区间

x_train = x_train.astype('float32') / 255.

x_test = x_test.astype('float32') / 255.

# 将图像数据展平成 784 维的向量

# 原始图像是 28x28,展平后为 784

x_train = x_train.reshape((len(x_train), np.prod(x_train.shape[1:])))

x_test = x_test.reshape((len(x_test), np.prod(x_test.shape[1:])))

print("训练数据形状:", x_train.shape) # (60000, 784)

print("测试数据形状:", x_test.shape) # (10000, 784)

# --- 2. 创建带噪声的数据 ---

# 我们的目标是让Autoencoder学习从噪声图像中恢复原始图像

noise_factor = 0.5

x_train_noisy = x_train + noise_factor * np.random.normal(loc=0.0, scale=1.0, size=x_train.shape)

x_test_noisy = x_test + noise_factor * np.random.normal(loc=0.0, scale=1.0, size=x_test.shape)

# 将像素值裁剪回 [0, 1] 区间

x_train_noisy = np.clip(x_train_noisy, 0., 1.)

x_test_noisy = np.clip(x_test_noisy, 0., 1.)

# --- 3. 构建Autoencoder模型 ---

# 输入维度

input_dim = np.prod(x_train.shape[1:])

# 编码器压缩后的维度 (潜在空间维度)

encoding_dim = 32

# 定义编码器

input_layer = layers.Input(shape=(input_dim,))

# "encoded" 是我们压缩后的表示

encoded = layers.Dense(encoding_dim, activation='relu')(input_layer)

# 定义解码器

# "decoded" 是我们重建的图像

decoded = layers.Dense(input_dim, activation='sigmoid')(encoded)

# 将输入层和解码器输出连接起来,构成完整的Autoencoder模型

autoencoder = models.Model(input_layer, decoded)

# 编译模型

autoencoder.compile(optimizer='adam', loss='binary_crossentropy')

# 打印模型结构

autoencoder.summary()

# --- 4. 训练模型 ---

# 注意:我们用带噪声的图像作为输入 x,用原始的干净图像作为目标 y

history = autoencoder.fit(

x_train_noisy, x_train,

epochs=20,

batch_size=256,

shuffle=True,

validation_data=(x_test_noisy, x_test)

)

# --- 5. 可视化结果 ---

# 用测试集中的带噪声图像进行预测

decoded_imgs = autoencoder.predict(x_test_noisy)

# 随机选择10张图片进行对比展示

n = 10

plt.figure(figsize=(20, 4))

for i in range(n):

# 显示带噪声的图像

ax = plt.subplot(2, n, i + 1)

plt.imshow(x_test_noisy[i].reshape(28, 28))

plt.gray()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

# 显示重建后的图像

ax = plt.subplot(2, n, i + 1 + n)

plt.imshow(decoded_imgs[i].reshape(28, 28))

plt.gray()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.suptitle("带噪声的图像 (上) vs. Autoencoder重建的图像 (下)")

plt.show()

代码解读(H3)

- 数据准备:我们加载MNIST数据,进行归一化和展平处理,使其适应全连接神经网络的输入格式。

- 创建噪声数据:这是本例的关键,我们人为地为干净图像添加高斯噪声,

x_train_noisy作为模型的输入,而x_train(原始干净图像)作为模型的“正确答案”或标签,这样,模型就被迫学习“去噪”这个任务。 - 构建模型:我们使用Keras的函数式API来构建模型。

Input层定义输入,然后通过Dense层构建编码器和解码器,最终的autoencoder模型接受原始输入,输出重建结果。 - 编译与训练:我们使用

adam优化器和binary_crossentropy损失函数(适用于像素值在0-1之间的情况),训练时,输入是噪声数据,目标是原始数据。 - 可视化:我们绘制了带噪声的图像和模型重建后的图像,你可以清晰地看到,Autoencoder成功地将模糊、有噪点的图像恢复成了清晰、干净的手写数字!

Autoencoder的四大核心应用场景(H2)

除了图像降噪,Autoencoder的应用远不止于此。

异常检测(Anomaly Detection)(H3)

- 原理:Autoencoder非常擅长在“正常”数据上进行训练,当它遇到与训练数据分布差异很大的“异常”数据时,重建效果会非常差(即损失函数值很高)。

- Python应用:在信用卡欺诈检测中,你可以用大量正常的交易数据训练一个Autoencoder,当一笔新的交易输入时,如果其重建误差远高于平均水平,系统就可以将其标记为潜在的欺诈行为。

数据降维与可视化(Dimensionality Reduction & Visualization)(H3)

- 原理:Autoencoder的编码器部分可以将高维数据映射到低维的潜在空间,这个过程类似于PCA(主成分分析),但能捕捉到更复杂的非线性关系。

- Python应用:你可以将编码器部分的输出(即

encoded层)提取出来,作为数据的新特征表示,可以将高维的词向量降到2维或3维,然后在散点图上进行可视化,观察文本的聚类情况。

特征提取(Feature Extraction)(H3)

- 原理:训练好的编码器可以被看作一个强大的特征提取器,它学到的“编码”比原始数据更具代表性,更适合作为其他监督学习任务(如分类、回归)的输入。

- Python应用:在图像分类任务中,你可以先用一个在大型数据集(如ImageNet)上预训练好的Autoencoder对图像进行特征提取,然后将提取到的特征输入到一个简单的分类器(如SVM)中,这通常能比直接使用原始像素获得更好的效果。

生成模型(Generative Models)(H3)

- 原理:通过在潜在空间中随机采样,然后通过解码器进行解码,可以生成全新的、与原始数据相似的数据。

- Python应用:这是更高级的变分自编码器的核心思想,VAE在潜在空间中学习了一个平滑的概率分布,这使得我们可以从该分布中采样,从而生成更逼真、更多样化的数据,如生成新的面孔、艺术作品等。

Autoencoder的进阶变种:从AE到VAE(H2)

标准Autoencoder的潜在空间通常是无结构的,不便于生成新数据,为了解决这个问题,变分自编码器 应运而生。

- 核心区别:VAE的编码器不再输出一个确定的编码,而是输出一个概率分布的参数(均值和方差),在解码时,VAE会从这个分布中随机采样一个编码,这使得潜在空间变得连续和可生成。

- 学习建议:当你掌握了标准Autoencoder后,VAE是下一个值得深入学习的方向,它在生成模型领域占据着举足轻重的地位。

总结与展望(H2)

我们从Autoencoder的基本原理出发,用Python和Keras亲手实现了一个图像降噪模型,并探讨了它在异常检测、数据降维等多个领域的强大应用。

Autoencoder是通往更高级的无监督学习和生成模型世界的一扇大门,它教会机器如何“思考”数据,而非仅仅“记忆”数据。

下一步,你可以尝试:

- 改变网络结构:尝试使用更深的网络或不同的激活函数,看看效果有何变化。

- 处理其他数据:将Autoencoder应用于其他类型的数据,如CSV表格数据或时间序列数据。

- 探索VAE:深入学习变分自编码器的原理,并尝试用Python实现它。

希望这篇“Autoencoder Python”指南能为你打开一扇新的大门,是时候去敲开代码的大门,探索更多可能了!

(可选)评论区互动

问题: 你正在使用或计划将Autoencoder应用到哪个具体场景中?欢迎在评论区留言分享,我们一起交流探讨!

#Autoencoder #Python #机器学习 #深度学习 #TensorFlow #Keras #数据科学 #AI #无监督学习 #图像降噪