下面我将从“如何排查原因”、“如何避免进程被关闭”以及“如果进程意外关闭了如何快速恢复”三个方面,为你提供一个完整的排查和解决方案。

第一步:排查原因(最重要)

当 Java 进程消失后,不要直接重启,先搞清楚它为什么被关闭,你可以通过以下几种方式来追溯原因。

检查系统日志 (System Logs)

系统日志是首要的排查对象,记录了系统级别的关键事件,包括服务的启停、崩溃、OOM Killer 等。

-

使用

journalctl命令 (现代 Linux 系统,如 CentOS 7+, Ubuntu 16.04+)# 查看所有与 java 相关的日志,按时间倒序排列 journalctl -u your-java-service-name --since "10 minutes ago" | grep -i java # 或者更通用的,查看内核日志和系统日志 journalctl -k --since "10 minutes ago" | grep -i java

-

查看

/var/log/messages或/var/log/syslog (图片来源网络,侵删)

(图片来源网络,侵删)在一些较旧的系统上,日志可能在这里。

# CentOS/RHEL tail -f /var/log/messages | grep -i java # Debian/Ubuntu tail -f /var/log/syslog | grep -i java

重点关注:

Out of memory: 如果日志中出现java.lang.OutOfMemoryError: Java heap space或Killed process XXX (java)等字样,几乎可以肯定是 OOM Killer (内存不足杀手) 干掉了你的进程。Segmentation fault: 表示程序发生了段错误,通常是 JVM 本身或其调用的本地库有 Bug。Service stopped: 如果是 systemd 管理的服务,日志会显示服务被停止,并可能附带停止原因。

使用 dmesg 查看内核日志

dmesg 显示的是内核环缓冲区中的消息,对于硬件和驱动级别的错误非常有用。

# 查看最近的内核消息,并过滤 java 相关 dmesg | tail -n 50 | grep -i java

重点关注:

oom-killer: 这是 OOM Killer 杀死进程的明确标志。[12345.67890] java invoked oom-killer: gfp_mask=0x..., order=0, oom_score_adj=0 [12345.67891] [<ffffffffa00e1a4d>] ? __alloc_pages_nodemask+0x1ad/0x280 [12345.67892] [<ffffffff8112d5f5>] oom_kill_process+0x1a5/0x330 [12345.67893] Memory cgroup out of memory: Kill process XXX (java) score XXX or sacrifice childsegfault: 段错误。

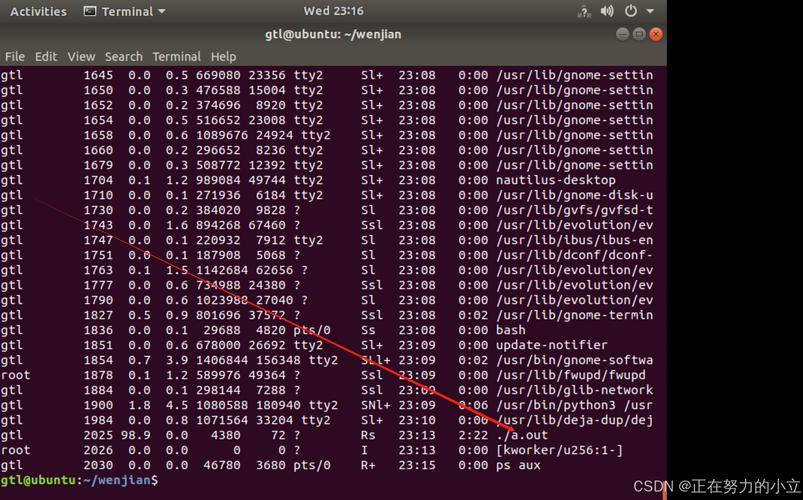

检查系统资源使用情况

在进程关闭前,系统资源是否已经耗尽?

- 内存: 使用

free -h或top/htop查看。Mem的available或free项长期接近 0,Swap被大量使用,那么内存不足是大概率事件。 - CPU: 使用

top/htop查看是否有进程长期占用 100% 的 CPU,导致系统无响应,进而可能被 OOM Killer 瞄准。 - 磁盘空间: 使用

df -h查看,如果磁盘(尤其是日志所在的分区)被写满,应用可能无法写入日志,甚至崩溃。

检查 Java 应用自身的日志

这是最直接的应用日志,通常包含了应用抛出的异常、错误信息等。

# 假设你的 Java 应用日志在 /var/log/myapp/ tail -f /var/log/myapp/application.log

重点关注:

OutOfMemoryErrorSocketException,Connection refused(网络问题)- 任何自定义的业务异常。

第二步:根据原因,采取解决方案

确定了原因后,就可以采取相应的措施了。

被 OOM Killer 杀死 (最常见)

这是 Java 进程被关闭的头号原因。

解决方案:

-

增加内存: 如果服务器资源允许,增加 JVM 的堆内存大小 (

-Xmx)。 -

优化内存使用: 分析内存快照 (Heap Dump) 找出内存泄漏的根源,并修复代码,可以使用工具如 Eclipse MAT, JProfiler, VisualVM 来分析。

-

调整 OOM Killer 策略 (不推荐,仅作为临时方案): 你可以为你的 Java 进程设置一个

oom_score_adj值,降低它被 OOM Killer 选中杀死的概率,值越小,越安全 (范围是 -1000 到 1000)。# 找到你的 java 进程的 PID pidof java # 假设 PID 是 12345,设置一个较低的值 echo -500 > /proc/12345/oom_score_adj

注意: 这治标不治本,如果系统真的内存不足,迟早会杀死其他进程,最佳实践仍然是解决内存问题本身。

进程崩溃 (Segmentation Fault)

这通常是 JVM 或其依赖的本地库(如 JNI 库)的 Bug。

解决方案:

-

升级 JDK/JRE: 切换到更新、更稳定的 JDK 版本。

-

更新依赖库: 确保所有 JNI 调用的本地库都是最新且兼容的版本。

-

生成 Core Dump 文件进行分析: 当进程发生段错误时,操作系统可以生成其内存的“快照”,即 Core Dump 文件,之后可以用 GDB 等工具分析。

-

启用 Core Dump:

# 创建一个目录存放 core 文件 mkdir /var/crashes chmod 777 /var/crashes # 修改 limits.conf,允许生成大的 core 文件 echo "* soft core unlimited" >> /etc/security/limits.conf echo "* hard core unlimited" >> /etc/security/limits.conf # 设置 core 文件名模式 echo "/var/crashes/core-%e-%p-%s-%t" > /proc/sys/kernel/core_pattern

-

使用 GDB 分析:

# 当再次崩溃后,用 GDB 加载 core 文件和对应的 JVM 可执行文件 gdb /path/to/java /var/crashes/core-java-12345-11-1600000000 # 在 GDB 中输入 where 或 bt 查看堆栈信息,定位问题代码 (gdb) bt

-

被脚本或管理工具手动关闭

kill 命令、systemctl stop、Ansible playbook 等。

解决方案:

- 检查

last命令: 查看最近登录系统的用户和操作。last

- 检查审计日志: 如果系统开启了审计功能 (

auditd),可以精确到谁在什么时间执行了什么命令。ausearch -k my_java_service -i

- 检查自动化工具的日志: 如果是 Jenkins, Ansible, Kubernetes 等工具管理的,检查它们自己的日志记录。

第三步:如何避免进程被关闭并实现高可用

即使修复了当前的问题,也需要建立一个健壮的体系来避免未来再次发生。

使用进程管理工具

强烈推荐! 不要直接用 nohup 或 & 在后台运行 Java 进程,使用专业的进程管理工具。

-

systemd(现代 Linux 的标准): 创建一个服务文件,/etc/systemd/system/myapp.service。[Unit] Description=My Java Application After=network.target [Service] User=javauser Group=javauser ExecStart=/usr/bin/java -jar -Xmx2g -Xms1g /opt/myapp/myapp.jar ExecStop=/bin/kill -15 $MAINPID SuccessExitStatus=143 Restart=on-failure RestartSec=10 StandardOutput=journal StandardError=journal [Install] WantedBy=multi-user.target

优点:

- 自动重启:

Restart=on-failure确保进程崩溃后自动重启。 - 资源限制: 可以通过

LimitNOFILE=,MemoryMax=等限制资源。 - 日志管理: 日志会自动输出到

journalctl,无需手动配置日志轮转。 - 状态管理:

systemctl start|stop|status|restart myapp非常方便。

- 自动重启:

-

supervisord(Python 写的,非常流行): 配置文件 (/etc/supervisor/conf.d/myapp.conf) 示例:[program:myapp] command=/usr/bin/java -jar -Xmx2g -Xms1g /opt/myapp/myapp.jar directory=/opt/myapp user=javauser autostart=true autorestart=true startretries=10 stopwaitsecs=3600 redirect_stderr=true stdout_logfile=/var/log/supervisor/myapp.log

优点:

- 跨平台,配置简单。

- 同样具备自动重启、日志管理等功能。

配置日志轮转 (Log Rotation)

日志文件无限增长会撑爆磁盘,导致应用崩溃,使用 logrotate。

创建配置文件 /etc/logrotate.d/myapp:

/var/log/myapp/*.log {

daily

missingok

rotate 7

compress

delaycompress

notifempty

create 644 javauser javauser

postrotate

# 如果使用 systemd,可以发送信号让服务重新打开日志文件

systemctl reload myapp.service || true

endscript

}设置监控和告警

被动等待问题发生是低效的,主动监控,在问题发生前或发生时立即告警。

- 监控工具:

- Prometheus + Grafana + JMX Exporter: 业界标准,可以监控 JVM 的堆内存、线程数、GC 情况、CPU 使用率等所有关键指标。

- Zabbix / Nagios: 传统的监控方案,同样强大。

- 告警设置:

- 当 JVM 堆内存使用率超过 80% 持续 5 分钟时告警。

- 当进程不存在时,立即告警。

- 当日志中出现

OutOfMemoryError关键字时,通过日志分析系统(如 ELK, Splunk)告警。

当 Linux 上的 Java 进程被关闭时,请遵循以下流程:

- 冷静排查:

journalctl/dmesg-> 看系统级日志,找 OOM 或崩溃信息。free/top-> 看系统资源,是否耗尽。- 应用日志 -> 看具体报错。

- 对症下药:

- OOM -> 增加内存 / 优化代码 / 调整 OOM 分值。

- 崩溃 -> 升级 JDK / 分析 Core Dump。

- 手动关闭 -> 检查操作记录。

- 亡羊补牢:

- 使用

systemd或supervisord实现进程自愈。 - 配置

logrotate防止日志撑爆磁盘。 - 建立监控告警,变被动为主动。

- 使用

通过这套组合拳,你可以极大地提高 Java 应用在 Linux 环境下的稳定性和可靠性。