Python异步任务调度终极指南:从零开始玩转APScheduler,告别阻塞烦恼

** 在现代Web应用和后台服务中,定时任务和异步处理是提升性能和用户体验的关键,本文将深入浅出地介绍Python中一款强大的任务调度库——APScheduler,并结合异步编程的精髓,教你如何构建一个高效、非阻塞的后台任务系统,无论你是Django/Flask开发者,还是Python后端工程师,这篇指南都将让你彻底掌握APScheduler,从容应对各种定时与异步场景。

引言:你是否也遇到了这些“定时”的烦恼?

想象一下这样一个场景:你的电商网站需要在每天凌晨3点自动清理过期的优惠券;你的数据分析平台需要每小时从多个API拉取最新数据;你的社交应用需要给活跃用户发送每日推送通知。

这些需求都指向了一个共同的技术点——定时任务调度。

如果你还在使用time.sleep()+循环的笨拙方式,或者依赖系统级的cron job,你可能会遇到以下痛点:

- 阻塞主线程:

cron在服务器上运行,与你的Python应用逻辑分离,难以动态管理任务(如添加、删除、修改)。 - 扩展性差: 当你的应用部署在多台服务器上时,

cron会导致任务重复执行。 - 功能单一: 难以实现基于时间间隔、日期、甚至是特定事件(如任务A完成后触发任务B)的复杂调度逻辑。

别担心,今天我们要介绍的 APScheduler (Advanced Python Scheduler),正是解决这些问题的“神器”,它是一个功能强大、使用灵活的Python库,能够让你在应用程序内部轻松实现各种复杂的调度任务,并且完美融入异步编程模型。

初识APScheduler:它是什么,能做什么?

APScheduler,即高级Python调度器,它是一个独立的第三方库,不与任何特定的框架或数据库绑定,这意味着你可以在任何Python项目中使用它,无论是脚本、命令行工具,还是Web应用(如Flask、Django、FastAPI)。

它的核心优势在于:

- 多种调度器类型: 支持基于内存、数据库(如SQLAlchemy、MongoDB)或Redis的后端,实现任务的持久化和分布式调度。

- 丰富的触发器: 支持日期、间隔、cron表达式等多种触发方式,满足各种定时需求。

- 强大的集成能力: 可以轻松集成到各种Web框架和异步事件循环中。

- 完善的任务管理: 支持动态添加、删除、暂停和恢复任务。

APScheduler核心组件:三大支柱

要熟练使用APScheduler,必须理解它的三个核心组件,它们共同构成了调度的工作流:

-

调度器: 这是APScheduler的大脑,你通过创建一个调度器实例来启动整个调度系统,它负责管理调度器、作业存储和执行器,并将它们串联起来。

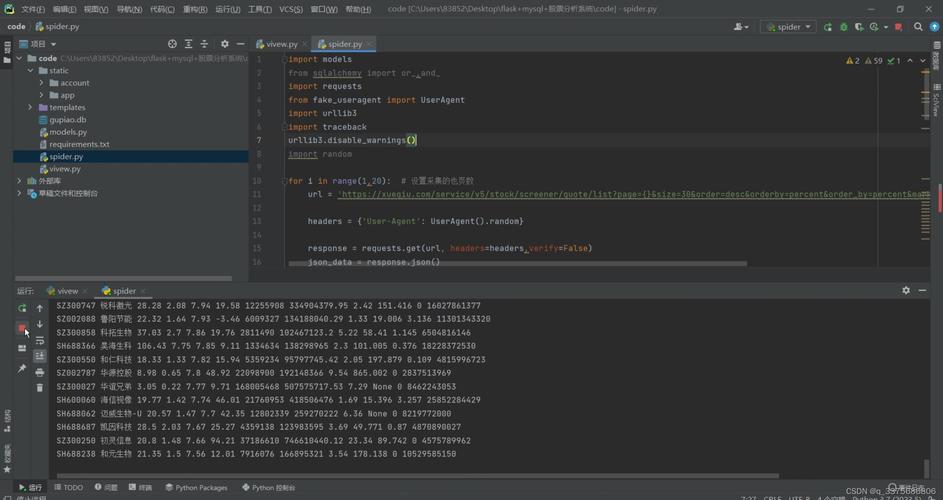

(图片来源网络,侵删)

(图片来源网络,侵删) -

作业存储: 这是调度器的“记忆库”,它负责存储所有定义好的任务(作业),APScheduler支持多种作业存储后端:

MemoryJobStore:默认选项,将作业存储在内存中,优点是速度快,但缺点是程序重启后所有任务都会丢失,适合单次运行脚本。SQLAlchemyJobStore:将作业存储在关系型数据库(如MySQL, PostgreSQL, SQLite)中,这是生产环境最常用的方式,可以实现任务的持久化和分布式调度。MongoDBJobStore/RedisJobStore:对于NoSQL数据库场景的完美支持。

-

执行器: 这是调度器的“手和脚”,当某个任务需要被执行时,调度器会将其交给执行器,执行器负责在新的线程或进程中运行任务,以避免阻塞主程序。

ThreadPoolExecutor:线程池执行器,适合执行I/O密集型任务(如网络请求、文件读写)。ProcessPoolExecutor:进程池执行器,适合执行CPU密集型任务(如复杂计算、图像处理)。AsyncIOExecutor:异步执行器,这是我们这篇文章的重点,它专门为Python的asyncio生态设计,可以在异步事件循环中无缝执行协程任务。

工作流程简述: 你定义一个任务 -> 将任务添加到调度器(并存入作业存储) -> 调度器根据触发器检查任务是否到期 -> 如果到期,则将任务交给执行器去执行。

实战演练:从同步到异步,玩转APScheduler

理论说再多不如动手实践,让我们通过几个例子,一步步掌握APScheduler。

最简单的入门 - 内存调度与同步任务

假设我们想每5秒打印一次 "Hello, APScheduler!"。

from apscheduler.schedulers.blocking import BlockingScheduler

import time

def my_job():

print(f"Hello, APScheduler! 当前时间: {time.ctime()}")

# 1. 创建一个阻塞式调度器

scheduler = BlockingScheduler()

# 2. 添加作业

# job_func: 要执行的函数

# trigger: 触发器,这里是'interval'(间隔)

# seconds: 间隔时间

scheduler.add_job(my_job, 'interval', seconds=5)

print("调度器已启动,按 Ctrl+C 退出...")

# 3. 启动调度器(这会阻塞当前线程)

try:

scheduler.start()

except (KeyboardInterrupt, SystemExit):

print("调度器已关闭。")

代码解析:

- 我们使用了

BlockingScheduler,它会阻塞主线程,让调度器在后台持续运行,这是最简单的用法,适合独立的脚本。 add_job方法用于添加任务,我们指定了函数名、触发器类型和间隔时间。

Web应用的优雅选择 - 集成Flask与异步任务

这是APScheduler最常见的应用场景,在Web应用中,我们不希望调度器阻塞主线程(否则用户请求就无法处理了),这时,我们可以使用BackgroundScheduler(后台调度器)。

假设我们有一个Flask应用,需要在后台异步发送邮件。

from flask import Flask

from apscheduler.schedulers.background import BackgroundScheduler

import atexit # 用于在程序退出时优雅地关闭调度器

app = Flask(__name__)

# 1. 创建一个后台调度器

scheduler = BackgroundScheduler()

# 2. 定义一个模拟的发送邮件任务

def send_email_reminder():

print(f"[{time.ctime()}] 正在发送邮件提醒...")

# 这里是实际发送邮件的代码,可以是同步的也可以是异步的

# 为了演示,我们让它睡3秒,模拟耗时操作

time.sleep(3)

print("邮件发送完成!")

# 3. 添加作业(cron表达式,每天上午9点执行)

scheduler.add_job(send_email_reminder, 'cron', hour=9, minute=0)

# 4. 在应用启动时启动调度器

scheduler.start()

# 注册一个退出处理函数,确保在Flask应用关闭时,调度器也被关闭

atexit.register(lambda: scheduler.shutdown())

@app.route('/')

def home():

return "Flask应用正在运行,后台调度器也已启动!"

if __name__ == '__main__':

app.run(debug=True)

代码解析:

BackgroundScheduler会在一个独立的线程中运行,不会阻塞Flask的主线程(运行在另一个线程中)。atexit.register确保了当你的Flask应用被关闭时(例如按下Ctrl+C),调度器也会被正确地关闭,实现优雅退出。

Python异步编程的完美拍档 - 结合asyncio

让我们进入正题:如何在异步环境中使用APScheduler? 这就是AsyncIOExecutor大显身手的地方。

假设我们正在使用FastAPI,需要每隔10秒异步地从数据库中获取一些数据。

import asyncio

from datetime import datetime

from apscheduler.schedulers.asyncio import AsyncIOScheduler

from apscheduler.executors.asyncio import AsyncIOExecutor

# 1. 定义一个异步任务函数

async def fetch_data_from_db():

print(f"[{datetime.now().strftime('%Y-%m-%d %H:%M:%S')}] 开始异步获取数据...")

# 模拟一个异步的I/O操作,比如等待数据库查询

await asyncio.sleep(2)

print("数据获取并处理完毕!")

async def main():

# 2. 创建执行器

executor = AsyncIOExecutor()

# 3. 创建异步调度器,并指定执行器

scheduler = AsyncIOScheduler(executor=executor)

# 4. 添加异步任务

# 注意:add_job的第一个参数可以直接是协程对象

scheduler.add_job(fetch_data_from_db, 'interval', seconds=10)

# 5. 启动调度器

scheduler.start()

print("异步调度器已启动...")

# 模拟主程序的其他异步任务

while True:

await asyncio.sleep(1)

print("主程序正在运行...")

if __name__ == '__main__':

# 运行主异步函数

asyncio.run(main())

代码解析与关键点:

AsyncIOScheduler:这是专门为asyncio设计的调度器。AsyncIOExecutor:这是专门用于执行协程任务的执行器。必须将这个执行器传递给调度器,否则协程函数将无法被正确执行。async def:我们的任务函数必须是async def定义的协程。await asyncio.sleep():在异步任务中,我们使用await来调用其他协程或等待I/O操作,这不会阻塞事件循环。asyncio.run(main()):这是启动顶级协程的标准方式。

为什么这很重要?

在异步应用(如FastAPI, aiohttp)中,事件循环是核心资源,任何阻塞操作都会让整个应用“卡住”,使用AsyncIOScheduler和AsyncIOExecutor,你的定时任务也能完全融入异步模型,在等待I/O时主动让出控制权,从而实现高并发和高性能。

进阶技巧与最佳实践

-

使用

job_defaults简化配置: 当你添加的许多任务都有相同的配置(如max_instances)时,可以在创建调度器时通过job_defaults统一设置,避免重复代码。scheduler = AsyncIOScheduler( job_defaults={ 'max_instances': 3 # 同一个任务最多同时运行3个实例 } ) -

任务的动态管理: APScheduler允许你通过

job_id来唯一标识一个任务,从而进行精细化管理。# 添加任务时指定job_id scheduler.add_job(my_task, 'interval', minutes=30, id='my_important_task') # 暂停任务 scheduler.pause_job('my_important_task') # 恢复任务 scheduler.resume_job('my_important_task') # 删除任务 scheduler.remove_job('my_important_task') -

错误处理与日志记录: 在实际生产环境中,任务执行失败是常有的事,务必为你的任务函数添加

try...except块,并妥善处理异常,配置好日志记录,方便追踪问题。 -

选择合适的作业存储: 对于需要跨服务器部署的分布式应用,强烈推荐使用

SQLAlchemyJobStore或RedisJobStore,这样,即使某个服务器宕机,任务信息也不会丢失,并且可以确保任务在集群中只被执行一次。

APScheduler,你Python工具箱中的瑞士军刀

通过本文的详细介绍,你应该已经掌握了APScheduler的核心概念和在不同场景下的使用方法,从简单的同步任务,到Web应用的后台调度,再到与asyncio的完美结合,APcheduler都展现出了其无与伦比的灵活性和强大功能。

选择正确的调度器和执行器是成功的一半。

- 独立脚本、简单任务:

BlockingScheduler - Web应用(Flask/Django):

BackgroundScheduler - 异步应用(FastAPI/aiohttp):

AsyncIOScheduler+AsyncIOExecutor

就去尝试在你的项目中引入APScheduler吧!用它来解放你的主线程,构建一个更高效、更健壮、更易于维护的后端服务,告别阻塞,拥抱异步,让Python的异步编程能力在你的手中发挥到极致。